RAG(检索增强生成)

RAG 的概念

以向量检索为核心,RAG 架构已成为解决大型模型面临的两个主要挑战的领先技术框架:获取最新的外部知识和减轻生成幻觉的问题。这种架构在众多实际应用场景中得到了广泛实施。

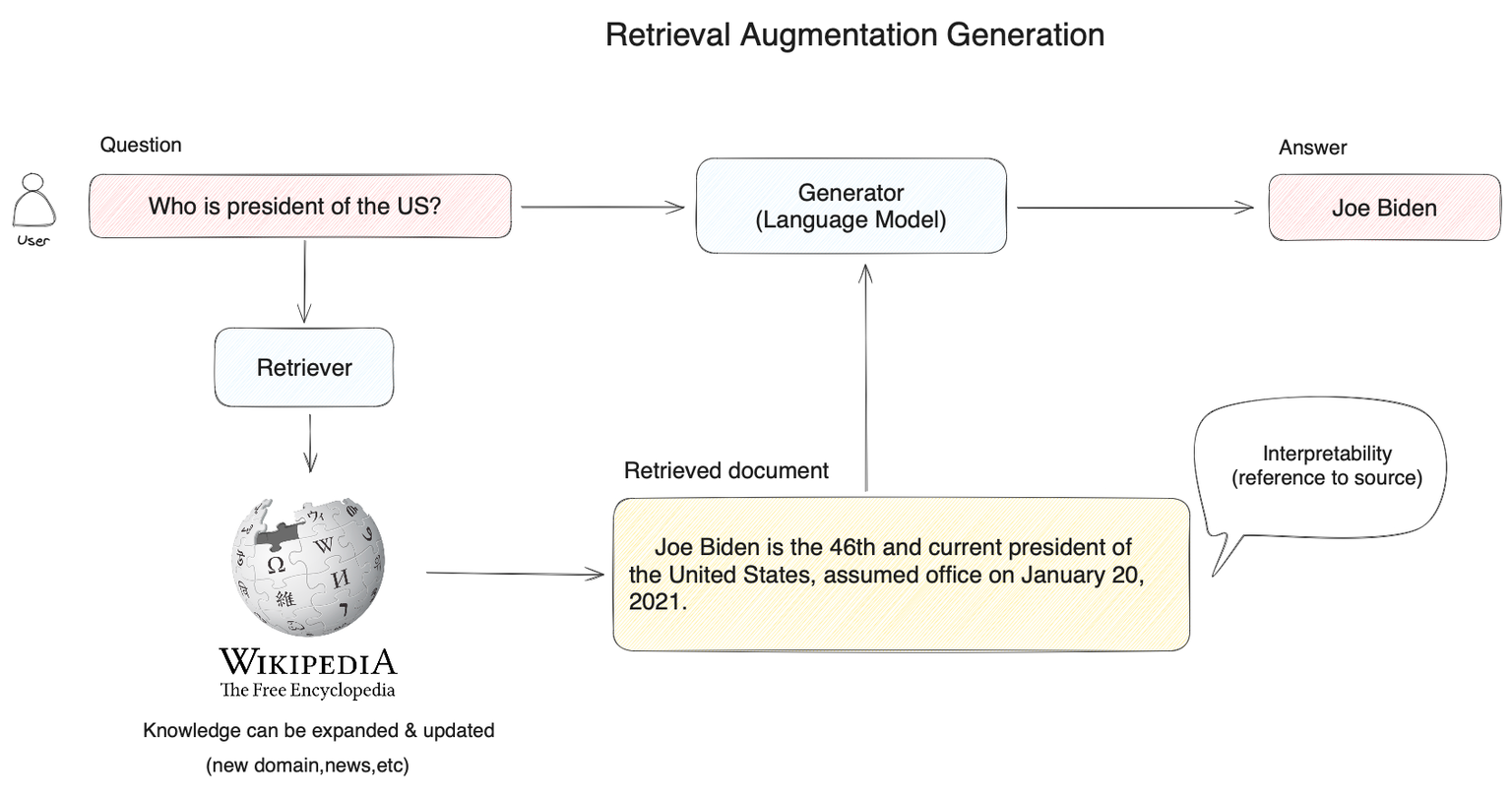

开发者可以利用这一技术以成本效益高的方式构建 AI 驱动的客服机器人、企业知识库、AI 搜索引擎等。这些系统通过自然语言输入与各种形式的组织知识进行交互。以下是 RAG 应用的一个代表性示例:

在下图中,当用户询问“美国总统是谁?”时,系统并不会直接将问题转交给大型模型以获取答案。相反,它首先在知识库(如图中所示的维基百科)中对用户的查询进行向量检索。系统通过语义相似性匹配找到相关内容(例如,“拜登是现任美国第 46 任总统……”),然后将用户的问题和找到的知识提供给大型模型。这为模型提供了足够且完整的知识,以回答该问题,从而产生更可靠的响应。

为什么重要?

我们可以将大型模型比作一位在各种人类领域知识渊博的超级专家。然而,这位专家也有其局限性;例如,它不了解你的具体情况,因为这类信息是私密的,并且在互联网上并不公开,因此它事先没有机会学习这些内容。

当你想雇用这位超级专家作为你的家庭财务顾问时,你需要允许他们查看你的投资记录、家庭开支和其他相关数据,才能在回答你的询问时提供专业建议。这使得他们能够根据你的具体情况提供量身定制的建议。

这就是 RAG 系统的作用:它帮助大型模型暂时获取它所缺乏的外部知识,使其在回答问题之前能够进行检索。

基于这个例子,RAG 系统最关键的方面是检索外部知识。专家提供专业财务建议的能力取决于准确找到必要的信息。如果专家检索到与财务投资无关的信息,比如家庭减肥计划,即使是最有能力的专家也会显得无能为力。

最后更新于